AI-gestuurd stemmen klonen kan het oplichters veel te makkelijk maken. ESET’s Global Security Advisor Jake Moore heeft dit getest, zodat jij deze les niet op de harde manier hoeft te leren.

Door een recente diefstal van zijn stem vroeg Jake Moore zich af hoe AIArtificial Intelligence. Meer nu al de potentie heeft om sociale ontwrichting te veroorzaken. ‘‘Ik was zo verrast door de kwaliteit van de gekloonde stem (en in die uiterst slimme, maar komische stijl van een van mijn collega’s) dat ik besloot om dezelfde software voor “snode” doeleinden te gebruiken en te zien hoe ver ik kon gaan om van een klein bedrijf te stelen – met toestemming, natuurlijk!’’

Spoiler alert: Het was ontzettend eenvoudig uit te voeren en kostte nauwelijks tijd.

AI: angstaanjagend of opwindend?

Films zoals Blade Runner en The Terminator gaven ons al een glimp van de mogelijkheden van AIArtificial Intelligence. Meer. Mede door zulke films hebben mensen vraagtekens gezet bij de meedogenloze mogelijkheden van wat de technologie zou kunnen voortbrengen. Maar pas nu, met krachtige databases, toenemende computerkracht en media-aandacht, hebben we AIArtificial Intelligence. Meer wereldwijd zien aankomen op een manier die zowel angstaanjagend als opwindend is. Met technologieën zoals AIArtificial Intelligence. Meer, is de kans groot dat we steeds creatievere en doortraptere aanvallen zullen zien, met schadelijke gevolgen.

”Artificial intelligenceis likely to be either the best or worst thing to happen to humanity.

Stephen Hawking

Denk als een crimineel

Bij de politie raden ze aan om te proberen te denken als een crimineel. Deze aanpak heeft een aantal zeer tastbare en toch ondergewaardeerde voordelen: hoe meer je denkt en zelfs handelt als een crimineel (zonder er daadwerkelijk een te worden), hoe beter je beschermd kunt zijn. Dit is essentieel om op de hoogte te blijven van de nieuwste dreigingen en om toekomstige trends te voorzien.

Om de huidige mogelijkheden van AIArtificial Intelligence. Meer te testen, heeft Jake Moore letterlijk de denkwijze van een digitale crimineel aangenomen en op ethische wijze een bedrijf aangevallen.

Het experiment

Onlangs vroeg Jake een bekende van hem of hij zijn stem mocht klonen en gebruiken om zijn bedrijf aan te vallen. Er werd toegestemd en het experiment begon met het maken van een stemkloon, met behulp van gemakkelijk verkrijgbare software. De bekende van Jake neemt vaak korte video’s op om zijn bedrijf te promoten op zijn YouTube kanaal. Door een paar van deze video’s aan elkaar plakken, was het gemakkelijk om een goede audio testbank te maken. Binnen een paar minuten was er een kloon van de stem gegenereerd, die net echt klonk. Daarna kun je deze stem alles laten afspelen.

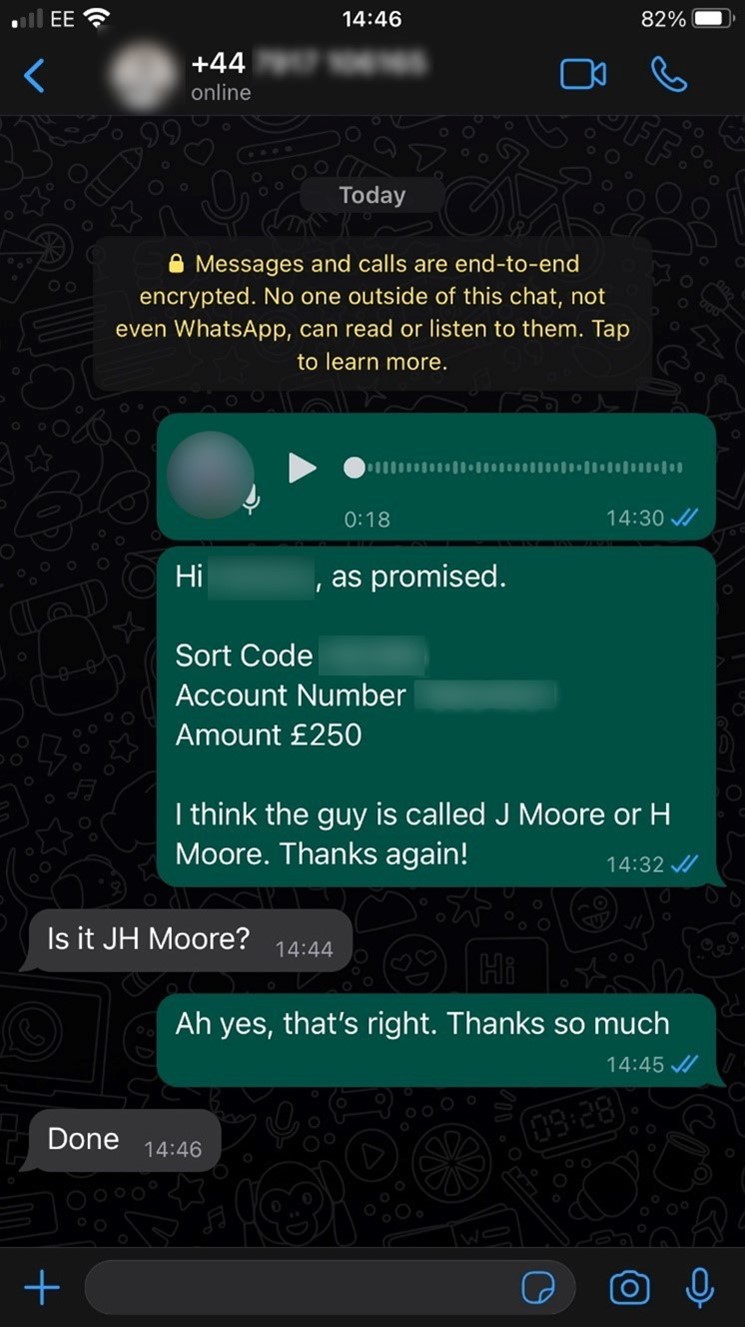

Om de aanvalActie waarbij iemand met opzet de beveiliging probeert uit te schakelen of te omzeilen om in een digitaal systeem te komen. nog authentieker te maken, besloot Jake ook het WhatsApp-account van de testpersoon te stelen met behulp van een SIM-swapaanval. Bij een aanvalActie waarbij iemand met opzet de beveiliging probeert uit te schakelen of te omzeilen om in een digitaal systeem te komen. als deze verzamelt een kwaadwillende jouw gegevens, bijvoorbeeld uit een datalekEen storing in de beveiliging van een computersysteem. Een gevolg hiervan kan zijn dat gegevens worden veranderd, deze verloren gaan of bij verkeerde personen terechtkomen.... Meer. Vervolgens belt hij jouw provider op om de medewerker te overtuigen jouw nummer over te zetten naar een simkaart die in het bezit van de kwaadwillende is. Dit is wederom met toestemming gedaan. Jake heeft hierna een spraakbericht vanaf het WhatsApp-account van zijn kennis, naar de financieel directeur van zijn bedrijf. In het bericht stond het verzoek £250 te betalen aan een “nieuwe aannemer”.

De testpersoon was op dat moment op vakantie, het ideale moment om toe te slaan dus. Het ingesproken bericht vermeldde waar hij was en dat hij de “floorplanner” betaald moest krijgen en zei dat hij de bankgegevens direct daarna apart zou sturen. Binnen 16 minuten na het eerste bericht had Jake £250 op zijn persoonlijke accountEen account is een stukje van een digitaal systeem waartoe een gebruiker toegang heeft. Bij een account hoort informatie over de gebruiker, zoals persoonlijke gegevens,... Meer staan.

Waarom is dit zo eenvoudig?

Het is schokkend hoe eenvoudig dit is, en hoe snel iemand ervan overtuigd kan zijn dat een stem echt is.

Dit niveau van manipulatie werkte door een dwingend aantal samenhangende factoren:

- Het telefoonnummer van de CEO verifieerde hem,

- Het verzonnen verhaal kwam overeen met de gebeurtenissen van die dag

- Het ingesproken bericht klonk natuurlijk precies als de CEO.

In de debriefing met het bedrijf, en bij nader inzien, verklaarde het ‘slachtoffer’ dat ze vond dat dit voor haar meer dan genoeg verificatie was om het verzoek uit te voeren. Onnodig om te zeggen dat het bedrijf sindsdien meer voorzorgsmaatregelen heeft genomen om hun financiën te beschermen. Ook de £250 is natuurlijk terugbetaald.

WhatsApp Business

Het WhatsApp-account van iemand telen via een SIM-swap kan een nogal langdradige manier zijn om een aanvalActie waarbij iemand met opzet de beveiliging probeert uit te schakelen of te omzeilen om in een digitaal systeem te komen. geloofwaardiger te maken, maar het gebeurt veel vaker dan je zou denken. Toch hoeven cybercriminelen niet zo ver te gaan om hetzelfde resultaat te bereiken.

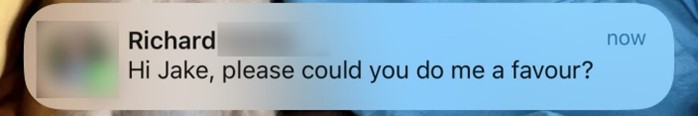

Jake vertelde namelijk ook onlangs het doelwit geweest te zijn van een aanvalActie waarbij iemand met opzet de beveiliging probeert uit te schakelen of te omzeilen om in een digitaal systeem te komen. die er op het eerste gezicht geloofwaardig uitzag. Iemand had hem een WhatsApp-bericht gestuurd dat zogenaamd afkomstig was van een vriend, die leidinggevende is bij een IT-bedrijf.

De interessante dynamiek hier was dat, hoewel hij gewend was om informatie te verifiëren, dit bericht aankwam met de gekoppelde contactnaam, in plaats van dat het verscheen als een nummer. Dit was vooral interessant omdat het nummer waar het bericht vandaan kwam niet opgeslagen stond in de contactenlijst van Jake. Hij veronderstelde dat het nog steeds zou worden weergegeven als een mobiel nummer, in plaats van de naam.

Blijkbaar hebben ze dit voor elkaar gekregen door eenvoudigweg een WhatsApp Business-account aan te maken, waarmee je elke naam, foto en e-mailadres kunt toevoegen aan een accountEen account is een stukje van een digitaal systeem waartoe een gebruiker toegang heeft. Bij een account hoort informatie over de gebruiker, zoals persoonlijke gegevens,... Meer en het er meteen echt kunt laten uitzien. Voeg dit bij “AIArtificial Intelligence. Meer voice cloning” en voila, we zijn aanbeland bij de volgende generatie social engineering.

Gelukkig wist Jake vanaf het begin dat dit een scam was, maar veel mensen zouden kunnen vallen voor deze eenvoudige social engineeringAls een aanvaller iemand misleidt door bijvoorbeeld in te spelen op nieuwsgierigheid of behulpzaamheid. Op deze manier probeert de aanvaller bijvoorbeeld aan informatie te komen... truc, die uiteindelijk kan leiden tot het vrijgeven van geld in de vorm van financiële transacties, prepaidkaarten of andere kaarten zoals Apple Card, allemaal favorieten onder cyberdieven.

Basismaatregelen

Nu machine learningOntwikkeling van technieken waarmee computers kunnen leren. en kunstmatige intelligentieTechnologie waarbij digitale systemen reageren op data, bijvoorbeeld afkomstig uit sensoren, en op basis daarvan zelfstandig acties ondernemen. met sprongen vooruitgaan, komt er de laatste tijd steeds meer beschikbaar voor de massa. We gaan we een tijdperk binnen waarin technologie criminelen efficiënter dan ooit tevoren begint te helpen. Onder andere door alle bestaande tools te verbeteren die helpen om de identiteitIdentiteit betekent wie je bent en wat jou anders maakt dan andere mensen. Het gaat over de dingen die je speciaal maken en hoe je... Meer en verblijfplaats van criminelen te verbergen.

Om terug te komen op de experimenten, zijn hier een aantal basismaatregelen om te voorkomen dat slachtoffer te worden van het klonen van stem en soortgelijke trucs:

- Volg altijd de officiële en vastgestelde procedures en regels van een organisatie. Sla geen stappen over, negeer geen regels en gebruik geen informele of onofficiële methoden moet gebruiken om sneller of makkelijker doelen te bereiken.

- Verifieer mensen en processen. Controleer bijvoorbeeld alle betalingsverzoeken dubbel met de persoon die (naar verluidt) het verzoek doet en laat zoveel mogelijk overschrijvingen door twee werknemers aftekenen.

- Voer ad hoc bewustzijnstrainingen uit voor alle medewerkers.

- Blijf op de hoogte van de laatste technologische trends en pas de training en verdedigingsmaatregelen hierop aan.

- Gebruik meerlaagse beveiligingssoftware.

Blijf veilig voor simswap-aanvallen

- Beperk de persoonlijke informatie die je online deelt; vermijd, indien mogelijk, het plaatsen van gegevens zoals je adres of telefoonnummer.

- Beperk het aantal mensen dat je berichten of ander materiaal op sociale media kan zien.

- Kijk uit voor phishing-aanvallen en andere pogingen om je te verleiden tot het verstrekken van je gevoelige persoonlijke gegevens.

- Als je telefoonprovider extra bescherming biedt op je telefoonaccount, zoals een pincode of wachtwoordReeks van letters, cijfers en of andere karakters waarmee een gebruiker in een computersysteem kan komen. Het is de bedoeling dat een gebruiker dit wachtwoord... Meer, zorg er dan voor dat je deze gebruikt.

- Gebruik tweefactorauthenticatie (2FA), in het bijzonder een authenticatieWat men doet om vast te stellen of een ander wel is wie hij zegt te zijn. De ander kan een persoon zijn, maar ook... app of een hardware authenticatieWat men doet om vast te stellen of een ander wel is wie hij zegt te zijn. De ander kan een persoon zijn, maar ook... apparaat.

Het belang van het gebruik van 2FATwee Factor Authenticatie. kan niet worden onderschat – zorg ervoor dat je het ook inschakelt op je WhatsApp-account en andere online accounts die het aanbieden.